服务公告

什么是高并发处理,业务抗峰的核心能力

发布时间:2025-10-03 09:59

在电商大促、直播带货、春运抢票等场景中,“每秒数万次请求” 是对系统的终极考验,而高并发处理就是应对这一考验的 “技术盾牌”。它并非单纯堆硬件,而是通过架构优化、资源调度、技术选型,让系统在海量请求下实现 “低延迟、高可用、无数据丢失” 的能力,核心价值是避免因并发过载导致的系统宕机、订单丢失、用户卡顿,直接决定业务在流量高峰的成败。本文将解析高并发处理的本质,拆解核心实现技术、典型应用场景与实践要点,结合案例说明如何构建抗高并发系统,帮助读者掌握支撑业务增长的关键能力。

一、高并发处理的核心本质

高并发处理的本质是 “系统资源的高效调度与瓶颈突破”,而非简单增加服务器数量。它针对 “大量同时发起的用户请求”(如每秒 1 万 + 请求),通过技术手段平衡 “请求量” 与 “系统承载力”:一方面让 CPU、内存、网络、存储等资源充分利用(如避免单台服务器过载、数据库查询拥堵);另一方面规避单点故障、数据一致性、响应延迟等问题。例如,某电商平时每秒处理 1000 次请求,双 11 峰值达 5 万次 / 秒,高并发处理通过 “分散请求、减少重复计算、异步解耦”,将系统响应时间从 100ms 控制在 300ms 内,订单成功率达 99.99%—— 这不是硬件升级的单一效果,而是架构与技术协同的结果。

二、高并发处理的核心技术

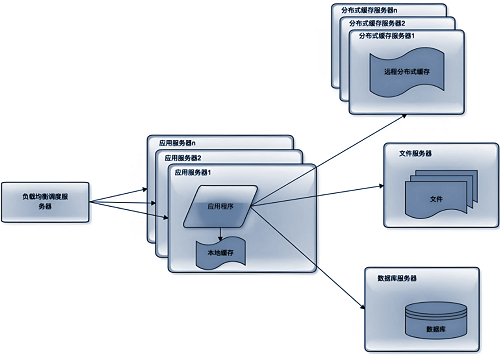

1.负载均衡:请求分流

将海量请求分发到多台服务器,避免单台过载。某 API 服务用 Nginx 作为负载均衡器,将每秒 3 万次请求均匀分发到 10 台应用服务器,每台仅处理 3000 次,CPU 利用率稳定在 60%;若未做负载,单台服务器 CPU 会瞬间达 100%,10 秒内宕机,请求失败率超 80%。

2.缓存技术:减少计算

用缓存存储热点数据,避免重复查询数据库。某资讯 APP 用 Redis 缓存首页头条、热门新闻,90% 的用户请求直接从缓存获取,无需访问数据库;优化前数据库每秒需处理 2 万次查询,CPU 利用率达 90%,优化后仅需 2000 次,响应时间从 500ms 降至 50ms。

3.异步处理:解耦耗时操作

用消息队列(如 RabbitMQ)处理耗时流程,让用户无需等待。电商下单场景中,用户点击 “提交” 后,订单数据先存入消息队列,异步处理库存扣减、物流通知;同步处理时用户需等待 2 秒,异步后响应时间缩至 200ms,同时避免 “下单成功但库存未扣” 的一致性问题。

4.集群与分片:突破单机瓶颈

通过集群冗余避免单点故障,用分片拆分海量数据。某数据库存储 10 亿条订单数据,按 “时间分片” 分散到 10 个节点,单节点仅存 1 亿条,查询某季度订单的速度从 10 秒缩至 1 秒;同时部署主从集群,主库故障时从库 1 秒切换,可用性达 99.99%。

三、高并发处理的典型应用场景

1.电商大促场景

如淘宝双 11、京东 618,每秒订单请求达 50 万次。通过 “分层缓存(本地缓存 + 分布式缓存)+ 异步队列 + 异地多活”,淘宝在双 11 期间实现 “订单不丢失、页面不崩溃”,用户支付响应时间 < 300ms,峰值订单创建成功率超 99.99%,支撑单日千亿级交易额。

2.直播互动场景

如直播弹幕、实时点赞,单场直播每秒请求达 10 万次。某直播平台用 “边缘计算 + 消息队列” 处理弹幕:用户发送的弹幕先到就近边缘节点,再通过队列异步分发到其他观众端,弹幕延迟 < 1 秒,百万观众同时发送弹幕无卡顿,服务器负载降低 70%。

3.春运抢票场景

如 12306 抢票高峰,每秒请求超 10 万次。通过 “静态资源 CDN + 动态请求分流 + 排队机制”,12306 将余票查询、订单提交等请求分开处理,用 CDN 加载静态页面(如车次列表),用队列控制下单流量,避免系统崩溃,余票查询响应时间 < 300ms。

随着云原生、Serverless 技术的发展,高并发处理正朝着 “轻量化、自动化” 演进 —— 未来通过 K8s 自动扩缩容、AI 流量预测,中小公司无需搭建复杂架构即可应对高并发;边缘计算将进一步降低响应延迟(如直播弹幕在边缘节点处理)。实践建议:中小业务从 “Redis 缓存 + Nginx 负载均衡” 入手,成本低、见效快;中大型业务逐步构建 “异步队列 + 分库分表 + 异地多活” 体系;所有业务需定期做压力测试与全链路监控,记住 “高并发处理的核心是未雨绸缪,而非临时救火”。

上一篇: 天机核心交换机通知

下一篇: CC攻击有哪些种类跟特点